本篇文章给大家谈谈python网页库,以及Python网页库对应的知识点,希望对您有所帮助,不要忘了收藏本站喔。

本篇文章目录概览:

如何抓取网页上的数据(如何使用Python进行网页数据抓取)

1、以下是使用Python编写爬虫获取网页数据的一般步骤: 安装Python和所需的第三方库。可以使用pip命令来安装第三方库,如pip install beautifulsoup4。 导入所需的库。例如,使用import语句导入BeautifulSoup库。 发送HTTP请求获取网页内容。可以使用Python的requests库发送HTTP请求,并获取网页的HTML内容。

2、要使用Python进行网页数据抓取,首先需要安装Python解释器。可以从Python官方网站下载并安装最新的Python版本。安装完成后,还需要安装一些相关的Python库,如requests、beautifulsoup、selenium等。

3、首先要明确想要爬取的目标。对于网页源信息的爬取首先要获取url,然后定位的目标内容。先使用基础for循环生成的url信息。然后需要模拟浏览器的请求(使用request.get(url),获取目标网页的源代码信息(req.text)。

值得收藏的Python第三方库

1、https://github.com/keon/algorithms 这里面集合众多核心算法的Python实现, 比如排序、图计算、 回溯、队列、流计算、堆、搜索、压缩等等。 全网最全的Python算法仓库 该仓库支持第三方库安装, 在python中进行调用, 非常方便。

2、scikit-image – 一个用于(科学)图像处理的 Python 库。thumbor – 一个小型图像服务,具有剪裁,尺寸重设和翻转功能。wand – MagickWand的Python 绑定。MagickWand 是 ImageMagick的 C API 。HTTP 使用HTTP的库。requests – 人性化的HTTP请求库。

3、Scikit-Learn 在机器学习和数据挖掘的应用中,Scikit-Learn是一个功能强大的Python包,我们可以用它进行分类、特征选择、特征提取和聚集。

4、learn-python3 这个存储库一共有19本Jupyter笔记本。它涵盖了字符串和条件之类的基础知识,然后讨论了面向对象编程,以及如何处理异常和一些Python标准库的特性等。

python用于web开发的第三方库有哪些

1、python第三方库包括:TVTK、Mayavi、TraitUI、SciPy。Python第三方库TVTK,讲解科学计算三维表达和可视化的基本概念。Python第三方库Mayavi,讲解科学计算三维表达和可视化的使用方法。Python第三方库TraitUI,讲解交互式科学计算三维效果应用的开发方法。Python第三方库SciPy,初步介绍科学计算工具箱。

2、在Python语言的库中,分为Python标准库和Python的第三方库,Python中常用的第三方库有Scapy、pywin3BeautifulSoup、SymPy和IPython。

3、Flask Flask是一个轻量级的web框架,可以快速构建web应用程序。Flask的优点之一是其灵活性,因为它允许您在自己的代码项目中实现所需的定制。Flask适合小型项目和初学者,因为它的习曲线较低。Django Django是一个功能强大的Web框架,适合大型项目。

如何用python爬取网站数据

1、以下是使用Python编写爬虫获取网页数据的一般步骤: 安装Python和所需的第三方库。可以使用pip命令来安装第三方库,如pip install beautifulsoup4。 导入所需的库。例如,使用import语句导入BeautifulSoup库。 发送HTTP请求获取网页内容。可以使用Python的requests库发送HTTP请求,并获取网页的HTML内容。

2、要使用Python进行网页数据抓取,首先需要安装Python解释器。可以从Python官方网站下载并安装最新的Python版本。安装完成后,还需要安装一些相关的Python库,如requests、beautifulsoup、selenium等。

3、python爬虫,需要安装必要的库、抓取网页数据、解析HTML、存储数据、循环抓取。安装必要的库 为了编写爬虫,你需要安装一些Python库,例如requests、BeautifulSoup和lxml等。你可以使用pip install命令来安装这些库。抓取网页数据 主要通过requests库发送HTTP请求,获取网页响应的HTML内容。

4、用python爬取网站数据方法步骤如下:首先要明确想要爬取的目标。对于网页源信息的爬取首先要获取url,然后定位的目标内容。先使用基础for循环生成的url信息。然后需要模拟浏览器的请求(使用request.get(url),获取目标网页的源代码信息(req.text)。

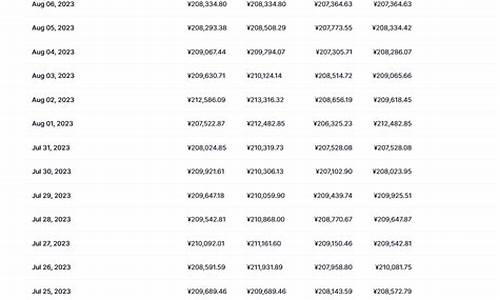

5、然后就是根据这个json文件编写对应代码解析出我们需要的字段信息,测试代码如下,也非常简单,主要用到requests+json组合,其中requests用于请求json文件,json用于解析json文件提取数据:点击运行这个程序,效果如下,已经成功爬取到我们需要的数据:至此,我们就完成了利用python网络爬虫来获取网站数据。

6、爬取所需要的数据 在本教程中,我使用了以下包(可以在 requirements.txt 中找到):Python 1 2 requests lxml 步骤一:研究该网站 打开登录页面 进入以下页面 “bitbucket.org/account/signin”。

关于python网页库和Python网页库的介绍到此就结束了,不知道您从中找到你需要的信息了吗 ?如果您还想了解更多这方面的信息,记得收藏关注本站。